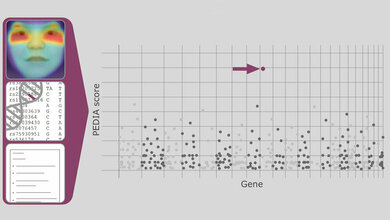

Bei der Auswertung medizinischer Bilddaten verspricht die künstliche Intelligenz (KI) Unterstützung und Entlastung für die Ärzte – insbesondere auch in der Krebsmedizin. Doch ob es darum geht, die Ausdehnung eines Hirntumors für die Therapieplanung zu vermessen oder die Rückbildung von Lungenmetastasen im Verlaufe einer Strahlentherapie zu dokumentieren: Zunächst müssen die Rechner die dreidimensionalen Bilddatensätze der CTs oder MRTs zu interpretieren lernen. Sie müssen unterscheiden können, welcher Bildpunkt zum Tumor gehört und welcher nicht. Diese Unterscheidung bezeichnen KI-Experten als semantische Segmentierung.

Entwicklung spezieller Algorithmen

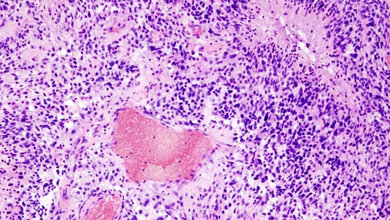

Für jede einzelne Aufgabenstellung – etwa ein Nierenkarzinom in CT-Bildern oder einen Brustkrebs im MRT zu erkennen – müssen Wissenschaftler spezielle Algorithmen entwickeln, die diese Unterscheidung vornehmen und Vorhersagen treffen können. Als Trainingsmaterial für das maschinelle Lernen dienen dabei Bilddatensätze, in denen Ärzte bereits per Hand markiert haben, was Tumor ist, was gesundes Gewebe und was andere wichtige anatomische Strukturen sind.

Die Entwicklung solcher Segmentierungs-Algorithmen erfordert Erfahrung und Expertenwissen. „Das ist nicht trivial und geht normalerweise mit zeitaufwändigem ‚Versuch und Irrtum‘ einher“, sagt Medizininformatiker Fabian Isensee, einer der Erstautoren der aktuellen Publikation. Zusammen mit seinen Kollegen in der Abteilung von Klaus Maier-Hein am DKFZ hat er nun eine Methode entwickelt, die sich dynamisch und vollautomatisch beliebigen Bilddatensätzen anpasst und so auch Personen mit geringeren Vorkenntnissen ermöglicht, selbstlernende Algorithmen für bestimmte Aufgabenstellungen zu konfigurieren.

Flexibles System

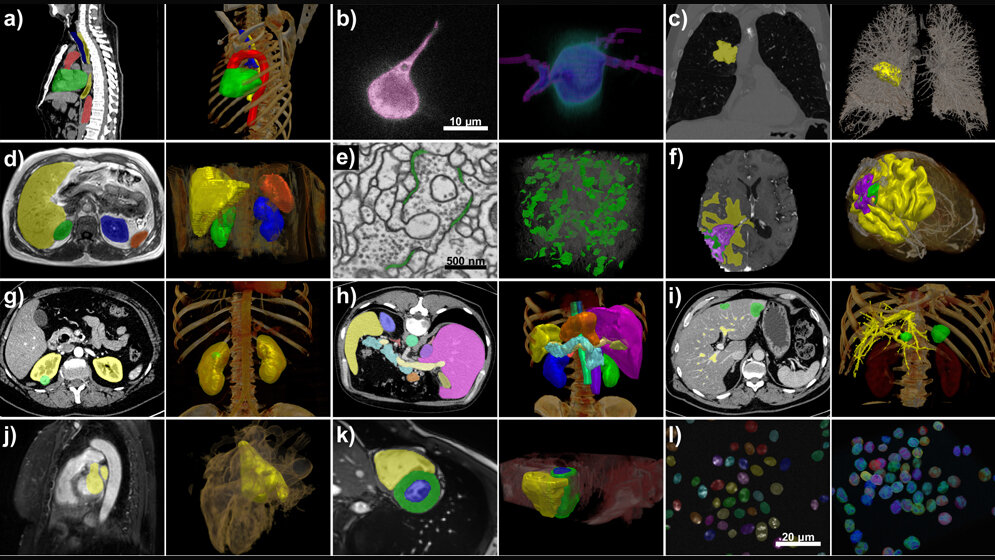

Das nnU-Net genannte Verfahren kann mit einer großen Bandbreite an Bilddaten umgehen: Neben den klassischen bildgebenden Verfahren wie CT und MRT lassen sich damit auch Bilder aus der Elektronen- und Fluoreszenzmikroskopie bearbeiten.

In internationalen Fachwettbewerben erzielten die DKFZ-Forscher mit nnU-Net bei 33 von 53 verschiedenen Segmentierungsaufgaben den besten Platz – obwohl sie dabei gegen hochspezifische und von Experten für individuelle Spezialfragen entwickelte Algorithmen antraten.

nnU-Net als Open-Source-Tool

Das Team um Klaus Maier-Hein stellt nnU-Net als Open-Source-Tool kostenfrei zum Download zur Verfügung. „nnU-Net ist sofort einsatzbereit, kann auf Bilddatensätzen trainiert werden und spezielle Aufgaben erfüllen – ohne dass dafür besondere computerwissenschaftliche Spezialkenntnisse oder eine außergewöhnliche Rechner-Ausstattung erforderlich wäre“, erklärt Klaus Maier-Hein.

Bislang wird die KI-unterstützte Auswertung medizinscher Bilddaten hauptsächlich im Forschungskontext genutzt und hat noch keinen breiten Einzug in die klinische Routineversorgung von Krebspatienten gehalten. Doch Medizininformatiker und Ärzte sehen großes Anwendungspotenzial, beispielsweise wenn es um hochrepetitive Aufgaben geht, wie sie häufig im Rahmen großer klinischer Studien auftreten. „nnU-Net kann dabei helfen, dieses Potenzial zu heben“, so Studienleiter Maier-Hein.

*Die Zielstrukturen für jeden Datensatz wurden in 2D auf die Rohdaten projiziert (links) und außerdem zusammen mit einem Volumen-Rendering der Rohdaten in 3D dargestellt (rechts). a: Herz (grün), Aorta (rot), Luftröhre (blau) und Speiseröhre (gelb) in CT-Bildern, b: synaptische Spalten (grün) in elektronenmikroskopischen Aufnahmen, c: Leber (gelb), Milz (orange), linke/rechte Niere (blau/grün) in T1-Inphase MRT, d: Bauchorgane in CT-Bildern, e: Leber (gelb) und Lebertumoren (grün) in CT-Bildern, f: Herz: rechter Ventrikel (gelb), linker Ventrikel (blau). Myokard des linken Ventrikels (grün) im MRT, g: Prostata (gelb) im MRT, h: Knoten in der Lunge (gelb) in CT-Bildern, i: Nieren (gelb) und Nierentumore (grün) in CT-Bildern, j: Gehirn: Ödem (gelb), Tumor (violett), Nekrose (grün) im MRT, k: linke Herzkammer (gelb) im MRI, l: Lebergefäße (gelb) und Lebertumoren (grün) im CT, m: Lungenkrebszellen (violett) in der Fluoreszenzmikroskopie n: Zellkerne in der Fluoreszenzmikroskopie

Fabian Isensee, Paul F. Jaeger, Simon A. A. Kohl, Jens Petersen, and Klaus H. Maier-Hein: nnU-Net: A Self-Configuring Method for Deep Learning-based Biomedical Image Segmentation. Nature Methods 2020, DOI: 10.1038/s41592-020-01008-z.

Quelle: DKFZ

Artikel teilen